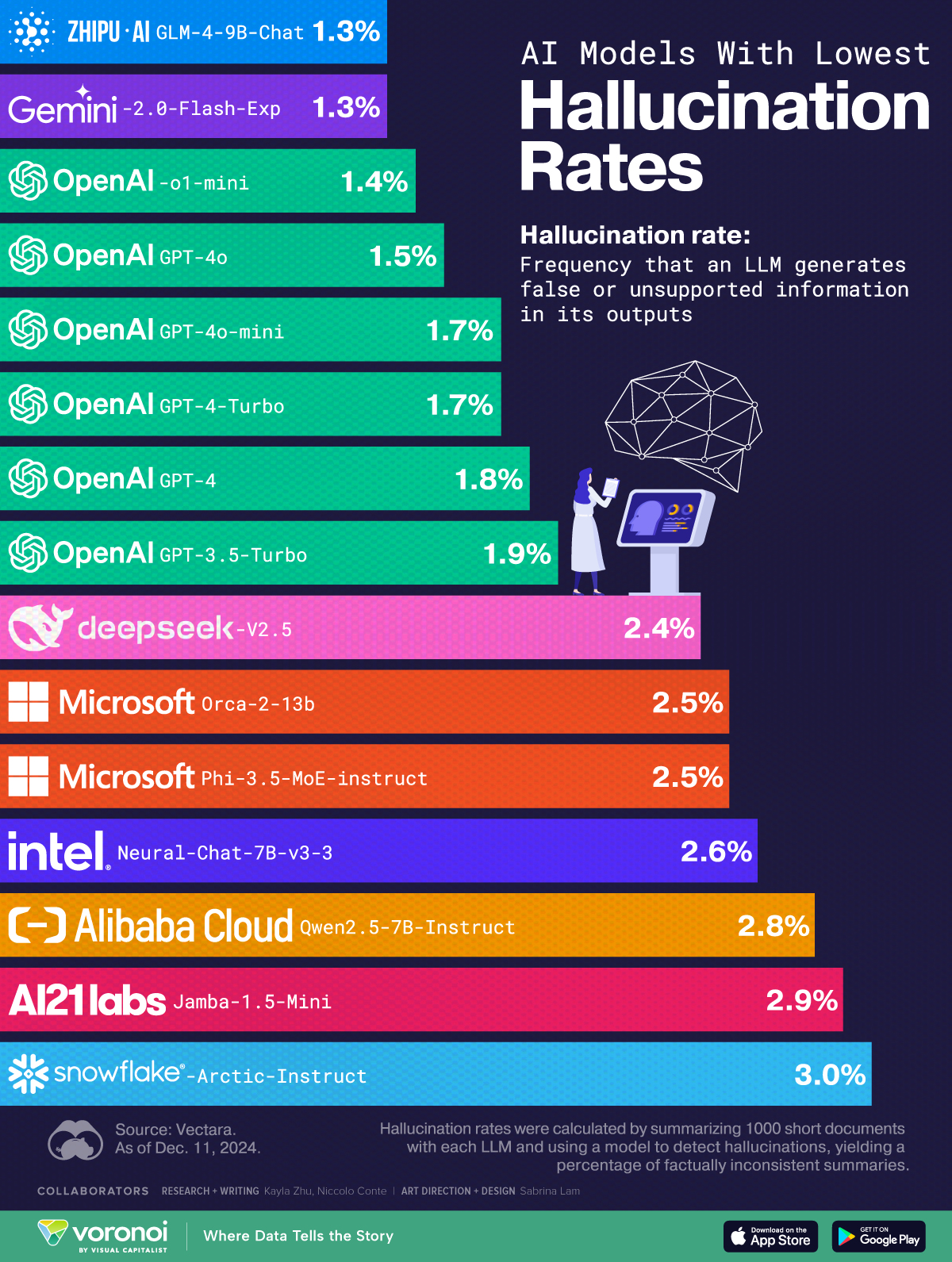

KI-Modelle sind mächtig, aber nicht perfekt. Ein entscheidender Faktor für ihre Zuverlässigkeit ist die Halluzinationsrate – also der Anteil an Antworten, die falsche oder ungestützte Informationen enthalten. 🔍

Was ist die Halluzinationsrate?

Sie zeigt, wie oft ein KI-Modell fehlerhafte Fakten oder unbegründete Inhalte generiert. Eine niedrige Halluzinationsrate bedeutet, dass die Antworten des Modells meist auf verlässlichen Daten basieren.

📊 Die Top-Performer:

Laut der neuesten Analyse von Vectara schneiden diese KI-Modelle am besten ab:

- ZHIPU AI GLM-4-9B-Chat und Gemini-2.0-Flash-Exp: Beide mit nur 1,3 % Halluzinationen – die derzeit verlässlichsten Modelle.

- OpenAI GPT-4 (1,8 %) und GPT-4-Turbo (1,7 %) sind ebenfalls Spitzenreiter, was die Konsistenz ihrer Antworten angeht.

- Microsoft Orca-2-13b und Intel Neural-Chat-7B rangieren mit 2,5–2,6 % etwas höher, bieten aber immer noch solide Ergebnisse.

📉 Warum ist das wichtig?

Je niedriger die Halluzinationsrate, desto vertrauenswürdiger ist das Modell für Anwendungen wie Bildung, Medizin oder Geschäftsanwendungen. Es reduziert das Risiko, falsche Informationen zu verwenden – ein entscheidender Vorteil in einer datengetriebenen Welt.

💡 Ein Blick in die Zukunft:

KI-Modelle werden ständig optimiert, um noch präziser zu werden. Doch wie bei jedem Werkzeug liegt es auch am Nutzer, die generierten Inhalte kritisch zu hinterfragen.

Source: VisualCapitalist (Screenshot am 2.2.2025, 12:58 Uhr)